SEO для оптового B2B: как агентство eLama работает над поисковой оптимизацией для dispensator.ru

- Заказчик

- dispensator.ru — это сайт, где компании могут найти безопасное решение по организации пространства в санузлах и других общественных пространств

- Задача

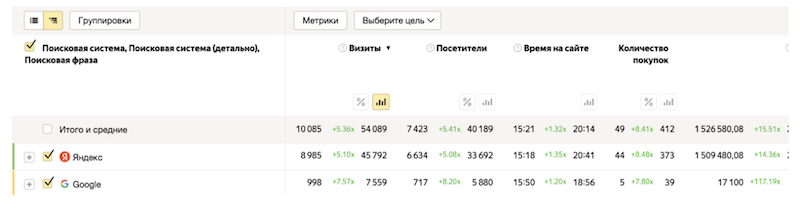

- Повысить видимость сайта заказчика в поисковых системах

С августа 2022 года специалисты агентства eLama занимаются поисковым продвижением сайта по продаже санитарно-гигиенического оборудования. О том, из каких шагов состоит эта работа, рассказывает участник команды по SEO Дмитрий Коновалов.

Продвижение в сфере B2B имеет свои нюансы. Мы должны учитывать, в частности, некоторые факты:

- решения о покупке в этой сфере зачастую принимаются долго и разными лицами (от исполнителя до топ-менеджера);

- здесь распространены низкочастотные запросы с поиском конкретной сложной позиции;

- здесь гораздо ниже цифры конверсии — и это нормально — при этом больше сегмент заинтересованных сторон и дороже стоимость сделки;

- в B2B большую роль играет брендинг.

Проект, над которым мы работаем, — это сайт, где компании могут найти безопасное решение по организации пространства в санузлах и других общественных пространств. На dispensator.ru можно оптом приобрести, например, сушилки для рук, диспенсоры и дозаторы, зеркала, унитазы, пеленальных столики и другие вещи, которые мы обычно встречаем в общественных ванных комнатах.

В этом кейсе мы шли по стандартным шагам — расскажем о них далее и поясним некоторые SEO-термины, которые могут вызвать вопросы у читателей.

Исправили основные технические проблемы

Любой технический аудит мы начинаем с проверки robots.txt — одного из основных файлов, влияющих на индексацию сайта поисковыми системами.

Файл robots.txt используется для того, чтобы указать поисковым роботам, какие страницы или разделы вашего сайта они могут или не могут сканировать. Частью стандартного синтаксиса файлов robots.txt является директива Clean-param — поэтому мы начали с того, что добавили директиву. Таким образом мы сообщаем поисковым роботам о том, какие параметры URL можно игнорировать при индексации страниц.

Это помогает управлять процессом индексации более точно и избегать индексации ненужных URL-адресов и эффективно управлять тем, как поисковые роботы взаимодействуют со страницами вашего сайта. В частности, робот Яндекса, используя эту директиву, не будет многократно перезагружать дублирующуюся информацию. Так увеличится эффективность обхода вашего сайта и снизится нагрузка на сервер.

Далее мы перешли к проверке sitemap.xml — файла, который содержит список всех страниц сайта, а также дополнительную информацию о них (частота обновлений, приоритеты страниц и дата их последнего изменения). Файл представляет собой структурированный формат, который помогает поисковым роботам более эффективно сканировать и индексировать содержимое вашего сайта. В нашем случае мы мы удалили из sitemap.xml страницы с 404 откликом и настроили автообновление файла.

Удаление 404-й страницы из sitemap.xml важно в первую очередь для того, чтобы избежать ошибочной индексации: когда поисковые роботы обнаруживают страницы с кодом ответа 404 в sitemap.xml, поисковые системы могут посчитать, что сайт содержит много недоступных страниц. Это может отрицательно сказаться на рейтинге сайта в поисковой выдаче.

XML-Sitemap — файл для ботов поисковых систем с перечнем всех страниц сайта в формате XML. Он нужен, чтобы поисковые системы более эффективно сканировали и индексировали содержимое сайта. Грамотно составленный sitemap.xml позволяет быстро и четко структурировать сайт для Яндекса и Google, что дает возможность видеть пользователям в результатах поиска нужные нам страницы.

После этого мы провели работу с мета-тегами и заголовками h1. Хорошо написанные уникальные мета-теги и заголовки H1 ( учитывающие не только содержание страницы, но и пользовательские запросы) — ключевой элемент в работе с контентом страниц, позволяющий влиять на видимость страниц сайта в поисковых результатах. Они помогают поисковым системам понять содержание страницы и ее тематику, что повышает ее релевантность для конкретных запросов пользователей. А включение ключевых слов в мета-теги и заголовки H1 помогает поисковым системам понять, о чем страница, и улучшает ее позиции в результатах поиска по этим ключевым словам.

Также мы исправили дубли title и description. Заполнили отсутствующие значения.

Мета-теги — часть программного HTML-кода, заключенная между тегом <head>...</head>. Они влияют на то, как отображается и какую позицию занимает страница в индексе, а также помогают продвигать ресурс именно по вашей ЦА.

Важно было исправить проблемы с «битыми» 404 страницами.Возникновение страниц с таким ответом сервера может произойти из-за неверной ссылки или потому, что запрашиваемая страница была удалена. «Битые» страницы опасны потерей трафика: посетители, попадая на такие страницы, могут покинуть ваш сайт, что негативно сказывается на его позициях в результатах поиска. Соответственно, SEO-показатели сайта теряются.

Мы также заметили и исправили проблемы с 301 редиректамина внутренних страницах. Редирект 301 — это метод перенаправления URL-адресов, который сообщает поисковым системам и браузерам, что страница была окончательно перемещена на новый URL. Когда посетитель пытается открыть старый URL, сервер отправляет им сообщение о том, что страница была перемещена навсегда, и автоматически перенаправляет его на новый URL.

На уровне пользователя такие перенаправления на неактуальные страницы могут просто-напросто раздражать, ухудшая пользовательский опыт. На уровне SEO проблемы в 301 редиректе негативно влияют на краулинговый бюджет (Crawl Budget) — это количество страниц сайта, которое сканирует робот поисковых систем за разовый визит. После сканирования релевантные по мнению робота страницы, начинают активно индексироваться. И только после этого сайт попадает в органическую выдачу.

Наконец, мы добавили тег <meta name="robots" content="noindex,follow">, который помогает управлять тем, как поисковые системы индексируют и проходят по ссылкам на вашем сайте. В нашем случае на сайте была проблема с дублированием контента страниц каталога на страницах пагинации (страницах-списках). Индексация таких страниц может привести к дублированию контента. Поэтому мы добавили тег — чтобы подсказать поисковым системам индексировать только основную страницу с уникальным контентом и не учитывать дубли (при этом поисковый робот индексировал товары).

Составили структуру сайта и рекомендации по новым теговым страницам каталога

Хорошая структура сайта может помогла улучшить видимость вашего контента в поисковых результатах. Чем лучше организован сайт, тем более вероятно, что поисковые системы будут правильно интерпретировать его содержание и показывать его в релевантных запросах пользователей.

Добавление новых теговых страниц, в свою очередь, может помочь расширить охват вашего сайта и привлечь больше целевой аудитории. Рекомендации по новым страницам каталога могут включать в себя ключевые слова, заголовки, описания и другие элементы, которые помогут страницам ранжироваться выше в поисковых результатах.

В рекомендациях мы составили MindMap потенциальной структуры сайта на основе конкурентов и спроса в сети интернет.

Настроили фид товаров для Яндекса

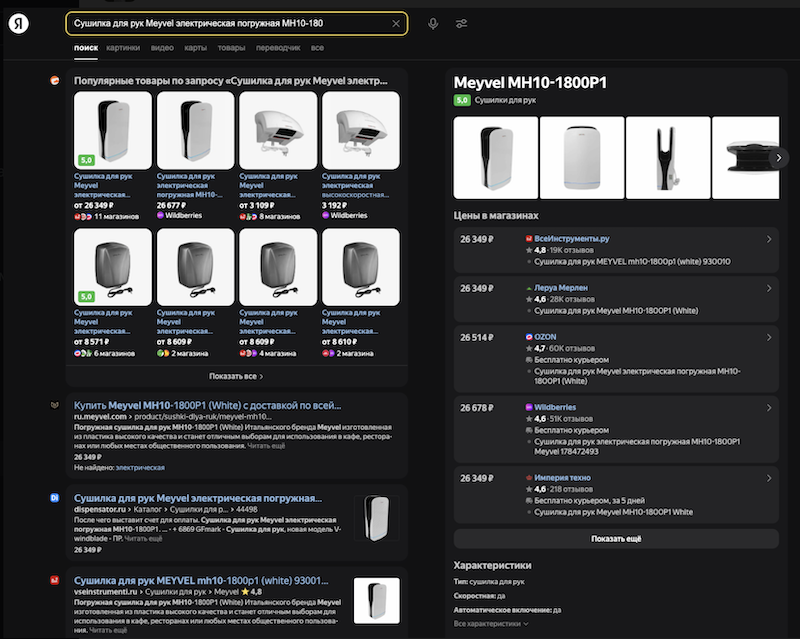

Чтобы привлечь больше заинтересованных потребителей в поисковой выдаче Яндекса, сгенерировали и установили в Яндекс Вебмастере YML-фид товаров.

В контексте SEO использование фида может привлечь больше пользователей по нескольким причинам. Во-первых, это увеличивает вашу видимость и шансы на привлечение новых клиентов — с помощью фида товары в поиске Яндекса выглядят информативно и привлекательно.

Во-вторых, использование фида увеличивает трафик на вашем сайте, что влияет на его ранжирование в поисковых системах.

YML-фид — это XML-файл, который содержит структурированную информацию о товарах или услугах для выдачи в поисковой системе Яндекс. YML расшифровывается как Yandex Market Language и представляет собой язык разметки на основе XML.

Выполнили закупку вечных ссылок и регистрацию в каталогах компаний

На этом этапе мы зарегистрировали новый кабинет Miralinks, отобрали площадки и отправили заявки на закупку ссылок. А также добавили сайт в каталоги компаний для большего охвата.

Биржа Miralinks — это система по размещению статей на сторонних ресурсах.

Когда другие ресурсы ссылаются на ваш сайт, поисковые системы рассматривают это как сигнал высокого качества контента. Чем больше ссылок вы получаете, тем вероятнее, что ваш сайт будет высоко ранжирован в поисковой выдаче.

Провели работу над исправлением большого количества малополезных страниц с помощью добавления сгенерированного контента

Для исправления статуса «Малополезные страницы» в Яндекс Вебмастере решили уникализировать похожие карточки товаров и наполнить их сгенерированным контентом (мы использовали нейросети, в том числе YandexGPT) на основе характеристик.

Выполнили корректировку главного меню для исправления переспама

Переспам — чрезмерное использование ключевых слов или других оптимизационных элементов на странице — может нарушать правила поисковых систем. За это поисковики могут наказывать сайты: снижать их рейтинг или исключать из поисковой выдачи.

В нашем случае мы заметили наличие переспама в главном меню и сократили названия подкатегорий до основной характеристики.

Составили контент-план для блога и предоставили статьи для наполнения

С точки зрения SEO активный блог приносит интернет-магазину несколько преимуществ: публикация уникального и качественного контента улучшает видимость сайта в поисковой выдаче, а регулярные публикации могут привлечь органический трафик с поисковых систем.

Прежде чем создавать статью на ту или иную тему, важно подготовить общий контент-план на ближайшее время и определить основные ключевые слова и фразы, которые будут использоваться в статьях конкретной тематики.

В нашем случае мы подготовили семантическое ядро по информационному направлению — в нем постарались покрыть все вопросы по тематике, чтобы раскрыть потенциал поискового трафика.

Составили рекомендации по названиям товаров

Для повышения плотности по ключу в категориях и разбавления их добавочными ключами подготовили рекомендации по формированию названий товаров.

Провели анализ фильтров товаров на основе конкурентов

Для добавления полезных активных ключей на страницы были составлены рекомендации по расширению фильтров товаров в категориях. Данная работа также повысила удобство использования сайтом.

Заключение

При работе с подобными интернет-магазинами стоит обращать внимание на множество факторов. Для начала исправить основные технические проблемы, которые могут помешать дальнейшему продвижению сайта. Изучить потенциальную семантику и составить структуру сайта для покрытия всего спроса потенциальных клиентов. Работать над повышением удобства пользования сайтом и увеличением ссылок с авторитетных ресурсов.

Хотите получать новую аудиторию из поисковых систем? Агентство eLama поможет вашему сайту быть в топе поисковой выдачи. Учитываем всех технические, контентные, экспертные и юридические тонкости.